И хората, и изкуственият интелект халюцинират – но не по един и същи начин

Счита се, че един Голям езиков модел (Large language model, LLM), който дава невярна информация, „халюцинира“, и в момента се полагат все повече усилия за минимизиране на този ефект. Но докато се занимаваме с тази задача, си струва да се замислим върху нашите собствени халюцинации – и как те влияят върху точността на езиковите модели, които създаваме.

Като разберем връзката между потенциала за халюцинации на изкуствения интелект и нашия собствен, можем да започнем да създаваме по-интелигентни модели, които в крайна сметка ще помогнат за намаляване на човешките грешки.

Думата „робот“ е измислена от Карел Чапек през 1921 г. в пиесата му „R.U.R.“, чието заглавие означава „Универсалните роботи на Росум“

Как хората халюцинират

Не е тайна, че хората си измислят информация. Понякога правим това умишлено, а понякога неволно. Последното е резултат от когнитивни пристрастия или „евристики“: умствени преки пътища, които развиваме чрез миналия си опит.

Тези преки пътища често са породени от необходимост. Във всеки един момент можем да обработим само ограничено количество от информацията, която залива сетивата ни, и да запомним само част от тази, която все пак достига вниманието ни.

Поради това нашият мозък трябва да използва заучени асоциации, за да запълни празнините и да отговори бързо на всеки въпрос или затруднение, което стои пред нас. С други думи, мозъците ни в крайна сметка понякога предполагат какъв би могъл да бъде правилният отговор въз основа на ограничени знания. Това се нарича „конфабулация“ и е пример за човешко предубеждение.

Предразсъдъците ни също могат да доведат до лоша преценка. Да вземем за пример предубеждението ни към автоматизация – склонност да предпочитаме информацията, генерирана от автоматизирани системи (като ChatGPT), пред информацията от неавтоматизирани източници. Тази пристрастност може да ни накара да пропуснем техните грешки и дори да действаме въз основа на абсолютно обратното на вярна информация.

Друг важен евристичен фактор е ефектът на ореола, при който първоначалното ни впечатление от нещо влияе на последващите ни взаимодействия с него. И предразсъдъка ни към информация, представена по по-лесен за четене начин.

Изводът е, че човешкото мислене често е оцветено от собствените си когнитивни наклони и изкривявания, а тези „халюцинаторни“ тенденции до голяма степен се проявяват и извън нашето съзнание.

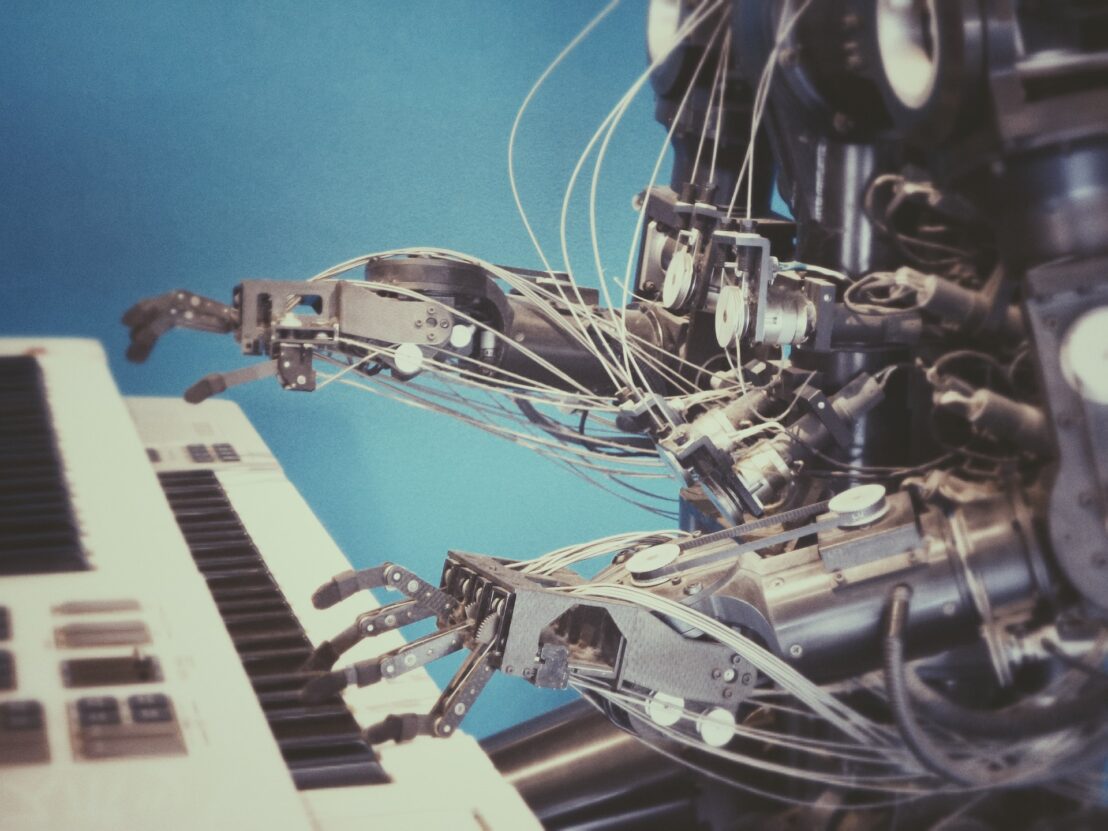

Как ИИ халюцинира

В контекста на езиковите модели халюцинациите са различни. Те не се опитват – като нас – да пестят ограничени умствени ресурси, за да осмислят света ефективно. „Халюцинирането“ в този контекст просто описва неуспешен опит да се предвиди подходящ отговор на информацията, която човекът им дава.

Въпреки това все пак има известна прилика между начина, по който хората и моделите халюцинират, тъй като моделите също го правят с цел „запълване на празнините“. Те генерират отговор, като предвиждат коя дума е най-вероятно да се появи следваща в дадена последователност въз основа на това, което е било – преди, и на асоциациите, които системата е научила при обучението си.

Подобно на хората, езиковите модели се опитват да предвидят най-вероятния правилен отговор. За разлика от хората обаче те правят това, без да разбират какво казват. Затова те могат да се окажат източник на безсмислици.

Що се отнася до причините за халюцинациите при моделите, съществуват редица фактори. Основният от тях е, че са обучавани на данни, които са погрешни или недостатъчни. Други фактори включват начина, по който системата е програмирана да се учи от тези данни, и начина, по който това програмиране се подсилва чрез по-нататъшно обучение с хора.

По-добри резултати заедно

И така, ако и хората, и машините са податливи на халюцинации (макар и по различни причини), кое е по-лесно да се поправи?

Поправянето на данните за обучение и процесите, които са в основата на езиковите модели и въобще изкуствения интелект, може да изглежда по-лесно от това да поправим себе си… Но в този случай не се отчитат човешките фактори, които оказват влияние върху системите с изкуствен интелект.

Реалността е, че нашите грешки и грешките на нашите технологии са неразривно свързани, така че поправянето на едното ще помогне за поправянето на другото. Ето няколко начина, по които можем да направим това.

- Отговорно управление на данните. Грешките в изкуствения интелект често произтичат от необективни или ограничени данни за обучението им. Начините за справяне с този проблем се свеждат до осигуряване на разнообразни и представителни данни, създаване на алгоритми, съобразени с различните човешки пристрастия, и прилагане на техники като балансиране на данните за отстраняване на изкривени или дискриминационни модели.

- Прозрачност и обясним ИИ. Въпреки горепосочените действия обаче пристрастията в ИИ все още може да има и да бъдат трудни за откриване. Като изучаваме как те могат да навлязат в една система и да се разпространят в нея, можем по-добре да обясним наличието им в резултатите. Това е в основата на течението за „обясним ИИ“, който има за цел да направи процесите на вземане на решения от ИИ по-прозрачни.

- Поставяне на интересите на обществото на преден план. Разпознаването, управлението и ученето от пристрастия в ИИ изисква човешка отговорност и интегриране на човешките ценности в тези нови технологии.

Като работим заедно по този начин, е възможно да изградим по-интелигентни системи, които могат да ни помогнат да държим под контрол всичките си собствени халюцинации.